Подключение к виртуальной машине hyper-vhyper-v virtual machine connection

Содержание:

- NUMANUMA

- Создание виртуального коммутатора с помощью Windows PowerShellCreate a virtual switch by using Windows PowerShell

- Использование сторонних программных продуктов

- 2.2 Логи задания: ищем стэк ошибки

- Плюсы Hyper-V на серверах VDS

- Основные сведения о виртуализации процессоров Hyper-VUnderstanding how Hyper-V virtualizes processors

- Как работают группы ЦПHow CPU Groups Work

- Простое управление Hyper-V Server 2019 через 5nine Manager

- Обмен файлами между физической и виртуальными машинами

- Какие функции имеет Hyper-V?What features does Hyper-V have?

NUMANUMA

Версии ядра Linux ниже 2.6.37 не поддерживают NUMA в Hyper-V с виртуальными машинами большего размера.Linux kernel versions earlier than 2.6.37 don’t support NUMA on Hyper-V with larger VM sizes. Эта проблема влияет в основном на дистрибутивы более ранних версий, в которых используется исходное ядро Red Hat 2.6.32, и была исправлена в Red Hat Enterprise Linux (RHEL) 6.6 (kernel-2.6.32-504).This issue primarily impacts older distributions using the upstream Red Hat 2.6.32 kernel, and was fixed in Red Hat Enterprise Linux (RHEL) 6.6 (kernel-2.6.32-504). В системах под управлением модифицированных ядер старше версии 2.6.37 или ядер RHEL старше 2.6.32-504 в командной строке ядра необходимо задать параметр загрузки в файле grub.conf.Systems running custom kernels older than 2.6.37, or RHEL-based kernels older than 2.6.32-504 must set the boot parameter on the kernel command line in grub.conf. Дополнительные сведения см. в статье базы знаний Red Hat 436883.For more information, see Red Hat KB 436883.

Создание виртуального коммутатора с помощью Windows PowerShellCreate a virtual switch by using Windows PowerShell

-

На рабочем столе Windows нажмите кнопку «Пуск» и введите любую часть имени Windows PowerShell.On the Windows desktop, click the Start button and type any part of the name Windows PowerShell.

-

Щелкните правой кнопкой мыши Windows PowerShell и выберите команду Запуск от имени администратора.Right-click Windows PowerShell and select Run as Administrator.

-

Найдите существующие сетевые адаптеры, выполнив командлет Get-NetAdapter .Find existing network adapters by running the Get-NetAdapter cmdlet. Запишите имя сетевого адаптера, который вы хотите использовать для виртуального коммутатора.Make a note of the network adapter name that you want to use for the virtual switch.

-

Создайте виртуальный коммутатор с помощью командлета New-VMSwitch .Create a virtual switch by using the New-VMSwitch cmdlet. Например, чтобы создать внешний виртуальный коммутатор с именем Екстерналсвитч, используя сетевой адаптер Ethernet и разрешить операционной системе управления включить общий доступ к этому сетевому адаптеру , выполните следующую команду.For example, to create an external virtual switch named ExternalSwitch, using the ethernet network adapter, and with Allow management operating system to share this network adapter turned on, run the following command.

Чтобы создать внутренний коммутатор, выполните следующую команду.To create an internal switch, run the following command.

Чтобы создать частный коммутатор, выполните следующую команду.To create an private switch, run the following command.

Дополнительные сценарии Windows PowerShell, посвященные усовершенствованным или новым функциям виртуального коммутатора в Windows Server 2016, см. в разделе Удаленный доступ к памяти и переключение на объединение внедренныхэлементов.For more advanced Windows PowerShell scripts that cover improved or new virtual switch features in Windows Server 2016, see Remote Direct Memory Access and Switch Embedded Teaming.

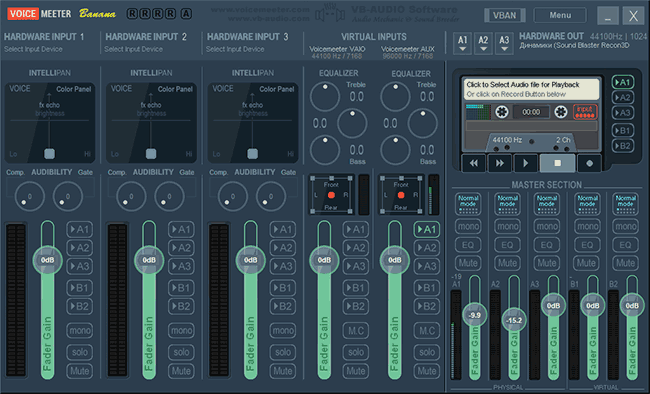

Использование сторонних программных продуктов

Тем не менее даже несмотря на средства, которыми может производиться виртуализация серверов Windows-систем, многие специалисты считают эту технологию несколько неэффективной и даже чрезмерно усложненной. Гораздо проще использовать уже готовый продукт, в котором аналогичные действия производятся на основе автоматического подбора параметров, а виртуальная машина обладает большими возможностями и гибкостью в управлении, настройке и использовании.

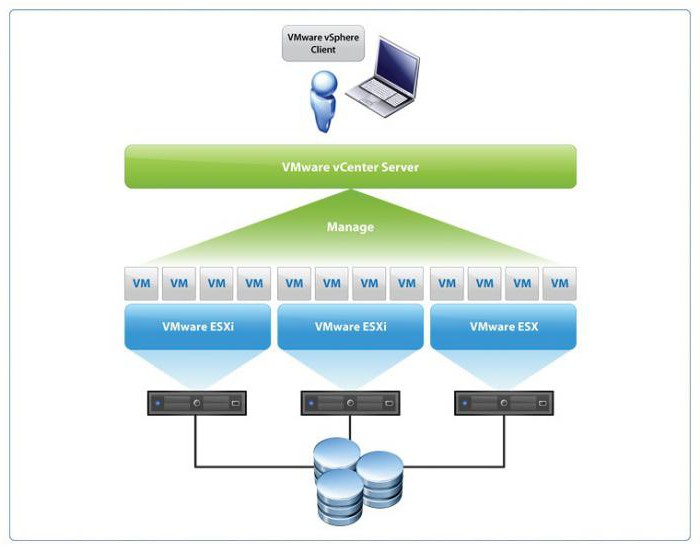

Речь идет об использовании таких программных продуктов, как Oracle VirtualBox, VMware Workstation (VMware vSphere) и других. Например, сервер виртуализации VMware может создаваться таким образом, чтобы сделанные внутри виртуальной машины аналоги компьютеров работали раздельно (независимо друг от друга). Такие системы можно использовать в процессах обучения, тестировании какого-либо программного обеспечения и т.д.

Кстати сказать, отдельно можно отметить, что при тестировании ПО в среде виртуальной машины можно использовать даже программы, зараженные вирусами, которые покажут свое действие только в гостевой системе. На основной (хостовой) ОС это не скажется ни коим образом.

Что же касается процесса создания компьютера внутри машины, в VMware vSphere виртуализация серверов, равно как и в Hyper-V, производится на основе «Мастера», однако, если сравнивать эту технологию с Windows-системами, сам процесс выглядит несколько проще, поскольку программа сама может предложить некое подобие шаблонов или автоматически вычислить нужные параметры будущего компьютера.

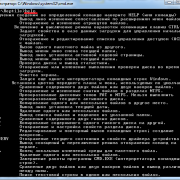

2.2 Логи задания: ищем стэк ошибки

Так как ошибка одна, но появляется для разных машин, то мы просто выбираем любое выполнение задания с ошибкой и анализируем его. Для начала идем в лог, который описывает обработку конкретной машины в задании — той, для которой вышла ошибка. Схема, по которой ищутся логи для задания — Veeam сервер\Backup\Название задания. В нашем случае это storepc.dom1.loc\Backup\Critical_FServers. Более подробно про структуру логов и где что лежит мы писали в отдельных статьях здесь и здесь.

В этой папке для задания резервного копирования можно встретить 3 типа логов:

-

Agent — логи компонента, который занимается передачей данных (Veeam Agent — Data mover). Если в названии есть слово Target, значит — это лог агента, который записывал данные на репозиторий. Если это задание репликации, то Target будет в папке на сервере, который использовался в качестве целевого прокси и писал данные на хранилище данных гипервизора (Datastore) куда реплицируем. Если в названии есть слово Source, значит — это лог агента, который читал данные с хранилища данных гипервизора (Datastore).

-

Job — это лог задания целиком. При общении с сапортом можно смело говорить просто “джоба”, и вас поймут.

-

Task — это лог подзадания (таски), из которого состоит задание (Job). Каждая виртуальная машина в задании обрабатывается отдельной таской, которая пишет свой отдельный лог.

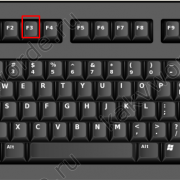

Мы открываем файл, начинающийся с Task и содержащий название VM. В нем просто ищем ошибку. Обычно нажимаем CTRL+End — это перебрасывает нас в самый низ лога, и потом крутим колесико вверх, пока не увидим нужную нам ошибку.

Стэк выглядит вот так, и нам он говорит, что был WMI запрос HviGetVmConfigPath: — этот запрос попытался получить путь до конфигурации VM по ID и в ответ получил пустой результат. Круто! Запрос! А дальше-то что?

А дальше нужно смотреть логи компонента, отвечающего за запросы, анализировать их, чтобы наконец построить теорию.

Плюсы Hyper-V на серверах VDS

H-V – не первая и не последняя среда, обеспечивающая функционирование виртуальных серверов. Есть ведь еще KVM, VMWare и многие другие… Просто именно эту технологию выбирают чаще всего, и на то есть определенные причины, они же плюсы. Вот некоторые из них:

-

Простота в использовании и привычный интерфейс.

-

Легкая установка на любой сервер – хоть Windows, хоть Linux.

-

Широкая аппаратная совместимость.

-

Удобное управление серверами.

-

Стабильная работа гипервизора и установленной на нем ОС.

-

Перенос работающего сервера с одного узла на другой посредством функции Live Migration.

-

Оперативная поддержка новых версий ОС Windows.

-

Возможность установки виртуальных рабочих столов VDI.

-

Удаленное подключение через консоль.

Основные сведения о виртуализации процессоров Hyper-VUnderstanding how Hyper-V virtualizes processors

Перед рассмотрением типов планировщиков гипервизора также полезно понимать архитектуру Hyper-V.Before considering hypervisor scheduler types, it’s also helpful to understand the Hyper-V architecture. Общую сводку можно найти в обзоре технологии Hyper-V.You can find a general summary in Hyper-V Technology Overview. Ниже приведены важные понятия, связанные с этой статьей.These are important concepts for this article:

-

Hyper-V создает и управляет секциями виртуальных машин, в рамках которых ресурсы вычислений распределяются и совместно используются, под контролем гипервизора.Hyper-V creates and manages virtual machine partitions, across which compute resources are allocated and shared, under control of the hypervisor. Секции обеспечивают строгие границы изоляции между всеми гостевыми виртуальными машинами, а также между гостевыми и корневыми машинами.Partitions provide strong isolation boundaries between all guest virtual machines, and between guest VMs and the root partition.

-

Корневой раздел сам является разделом виртуальной машины, хотя у него есть уникальные свойства и более широкие привилегии, чем Гостевые виртуальные машины.The root partition is itself a virtual machine partition, although it has unique properties and much greater privileges than guest virtual machines. Корневой раздел предоставляет службы управления, управляющие всеми гостевыми виртуальными машинами, обеспечивает поддержку виртуальных устройств для гостей и управляет всеми операциями ввода-вывода для гостевых виртуальных машин.The root partition provides the management services that control all guest virtual machines, provides virtual device support for guests, and manages all device I/O for guest virtual machines. Корпорация Майкрософт настоятельно рекомендует не выполнять никакие рабочие нагрузки приложений в корневом разделе.Microsoft strongly recommends not running any application workloads in the root partition.

-

Каждый виртуальный процессор (вице-президент) корневого раздела сопоставляется с 1:1 базовым логическим процессором (LP).Each virtual processor (VP) of the root partition is mapped 1:1 to an underlying logical processor (LP). Вице-президент узла всегда выполняется в одном базовом LP — миграция ВПС корневого раздела отсутствует.A host VP always runs on the same underlying LP – there is no migration of the root partition’s VPs.

-

По умолчанию LPs, на котором размещен ВПС, может также запускать гостевой ВПС.By default, the LPs on which host VPs run can also run guest VPs.

-

Низкоуровневая виртуальная машина может быть запланирована для запуска на любом доступном логическом процессоре.A guest VP may be scheduled by the hypervisor to run on any available logical processor. В то время как планировщик низкоуровневой оболочки следит за локализацией временного кэша, топологией NUMA и многими другими факторами при планировании гостевого вице-президента, в конечном счете, его можно запланировать на любом сервере LP.While the hypervisor scheduler takes care to consider temporal cache locality, NUMA topology, and many other factors when scheduling a guest VP, ultimately the VP could be scheduled on any host LP.

Как работают группы ЦПHow CPU Groups Work

Распределение вычислительных ресурсов узлов между группами ЦП обеспечивается гипервизором Hyper-V с помощью вычисленного ограничения группы ЦП.Allocation of host compute resources across CPU groups is enforced by the Hyper-V hypervisor, using a computed CPU group cap. Ограничение группы ЦП — это часть общей мощности ЦП для группы ЦП.The CPU group cap is a fraction of the total CPU capacity for a CPU group. Значение ограничения группы зависит от класса группы или назначенного уровня приоритета.The value of the group cap depends on the group class, or priority level assigned. Вычисленное ограничение группы можно рассматривать как «количество времени ЦП в LP».The computed group cap can be thought of as «a number of LP’s worth of CPU time». Этот бюджет группы является общим, поэтому если активна только одна виртуальная машина, она может использовать выделение ресурсов всей группы.This group budget is shared, so if only a single VM were active, it could use the entire group’s CPU allocation for itself.

Ограничение группы ЦП вычисляется как G = n x C, где:The CPU group cap is calculated as G = n x C, where:

- G — это количество узлов LP, которое необходимо назначить группеG is the amount of host LP we’d like to assign to the group

- n — общее число логических процессоров (LPS) в группе.n is the total number of logical processors (LPs) in the group

- В — это максимальное выделение ресурсов ЦП, то есть класс службы, который требуется для группы, выраженный в процентах от общей вычислительной мощности системы.C is the maximum CPU allocation — that is, the class of service desired for the group, expressed as a percentage of the system’s total compute capacity

Например, рассмотрим группу ЦП, настроенную с 4 логическими процессорами (LPs), и ограничение 50%.For example, consider a CPU group configured with 4 logical processors (LPs), and a cap of 50%.

- G = n * CG = n * C

- G = 4 * 50%G = 4 * 50%

- G = 2 время ЦП для всей группы в LPG = 2 LP’s worth of CPU time for the entire group

В этом примере для группы ЦП «G» выделяется 2-е время ЦП.In this example, the CPU group G is allocated 2 LP’s worth of CPU time.

Обратите внимание, что ограничение группы применяется независимо от числа виртуальных машин или виртуальных процессоров, привязанных к группе, и вне зависимости от состояния (например, завершения работы или запуска) виртуальных машин, назначенных группе ЦП.Note that the group cap applies regardless of the number of virtual machines or virtual processors bound to the group, and regardless of the state (e.g., shutdown or started) of the virtual machines assigned to the CPU group. Таким образом, каждая виртуальная машина, привязанная к одной и той же группе ЦП, будет принимать долю общего количества ресурсов ЦП группы, и это изменится на число виртуальных машин, привязанных к группе ЦП.Therefore, each VM bound to the same CPU group will receive a fraction of the group’s total CPU allocation, and this will change with the number of VMs bound to the CPU group

Таким образом, так как виртуальные машины привязаны к виртуальным машинам или не привязаны к ним из группы ЦП, необходимо перенастроить общее ограничение группы ЦП и настроить его для поддержки требуемого ограничения на виртуальную машину.Therefore, as VMs are bound or unbound VMs from a CPU group, the overall CPU group cap must be readjusted and set to maintain the resulting per-VM cap desired. Администратор узла виртуальной машины или программный уровень управления виртуализацией отвечает за управление групповыми политиками по мере необходимости для достижения требуемого распределения ресурсов ЦП для каждой виртуальной машины.The VM host administrator or virtualization management software layer is responsible for managing group caps as necessary to achieve the desired per-VM CPU resource allocation.

Простое управление Hyper-V Server 2019 через 5nine Manager

Раньше программа 5nine Manager для управления Hyper-V была другой. Я рассказывал о ней в отдельной статье. Сейчас этой программы вообще нет, а вместо нее 5nine Cloud Manager. Он более громоздкий и тормозной. Для установки требует sql сервер. Подойдет бесплатная редакция express. Нужно отдельно ставить серверную часть, отдельно консоль для управления, отдельно агент на hyper-v сервер.

Все стало намного сложнее по структуре, но в целом, если вам не хочется заморачиваться с описанными выше действиями, то можно попробовать с 5nine. В целом, процесс простой и выполняется все мышкой и визардами с кликанием далее — делее — делее. Чтобы все было понятно, расскажу по этапам.

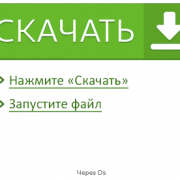

- Скачиваете и устанавливаете Microsoft SQL Server Express ни гипервизор.

- Скачиваете 5nine Cloud Manager. Устанавливаете на гипервизор серверную часть приложения, которая работает с sql базой, на машину управления ставите консоль для подключения к серверной части.

- Подключаетесь консолью и устанавливаете бесплатную лицензию, которая придет в письме после регистрации на сайте программы. Лицензия сроком на год, потом не знаю, что с ней делать, придется продлевать или будет и так работать. На прошлых версиях программы работала и так, продлевать было не обязательно.

- Ставите консоль на гипервизор и подключаетесь теперь напрямую с гипервизора через rdp. Сразу так не сделал, потому что с гипервизора нельзя было добавить лицензию. Выскакивала ошибка. Наверно связано с тем, что гипервизор без gui, а визарду по добавлении лицензии он нужен. Могли бы это как-то исправить, было бы проще. Раньше все можно было сразу делать на гипервизоре.

Теперь подробнее и с картинками. Скачиваем и устанавливаем на Hyper-V Microsoft SQL Server Express с сайта Microsoft. Выбирайте тот же язык, что и в гипервизоре. Установка подойдет дефолтная. Установщик можно передать так же, как я показывал раньше, через \\hyperv2019\c$.

Дальше ставите 5nine Cloud Manager, серверную часть. В установщике она называется 5nine Management Service.

Установщик сам найдет установленную локально базу. В качестве авторизации в базе используйте системную учетную запись windows пользователя, от которого вы ставили SQL Server Express. Все остальные настройки установщика я оставлял дефолные.

Теперь переходите на любую клиентскую систему windows, с которой есть доступ к гипервизору и устанавливайте туда консоль управления.

Подключайтесь через эту консоль и добавляйте лицензию, которую вам должны были прислать на почту вместе со ссылкой на скачивание программы.

После того, как добавите лицензию, можно идти на гипервизор, ставить туда же консоль и подключаться. После установки, ярлык для запуска будет лежать в C:\Users\All Users\Desktop. Я запускал оттуда. Когда запустите, сверните все, что открыто. Окно авторизации будет в фоне. Я не сразу это заметил и не мог понять, почему программа не запускается. По факту, она нормально работает на самом гипервизоре, кроме подключения к экрану виртуальной машины. Тут будет ошибка 🙁 А все остальное вроде работает.

Далее нужно добавить гипервизор в панель и дождаться, пока установится агент.

После установки агента, гипервизор с виртуальными машинами появится в панели.

Конечно, все получилось не так удобно, как хотелось бы, но в целом программа функциональная. Все основные действия с виртуальными машинами производить в ней можно. Жаль, что нельзя обойтись только гипервизором. Было бы удобно, если бы все работало на нем.

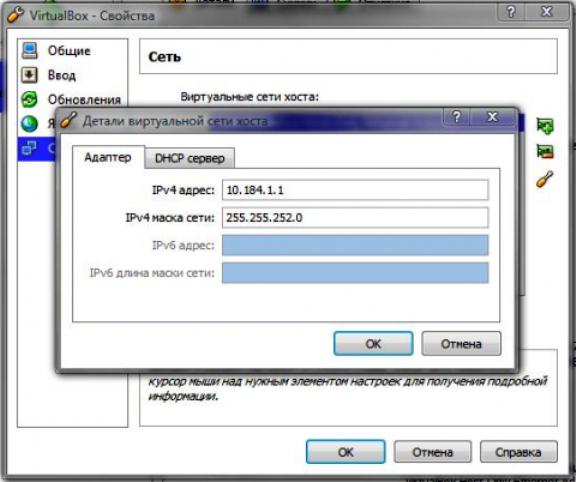

Обмен файлами между физической и виртуальными машинами

По ходу работы с виртуальной машиной регулярно возникает необходимость скопировать на нее файлы с физической, либо наоборот. Я опишу несколько способов решения этой задачи.

Общие сетевые папки

Этот способ работает во всех изданиях Windows 10. Поскольку в нашем распоряжении есть локальная сеть, можно использовать общие папки для обмена файлами. Фактически инструкции ниже сводятся к основам создания общих папок.

Доступ с виртуальной машины на физическую

Картинка стоит тысячи слов, как говорят американцы.

На рисунке показан проводник виртуальной машины (VIRTUAL-PC), откуда осуществляется доступ к физической машине (VADIK-PC). Как только вы введете учетные данные аккаунта, доступ к его профилю будет в вашем распоряжении.

Возможно, вы захотите сделать общей папку, расположенную на физической машине вне своего профиля. Для этого достаточно задействовать стандартные средства предоставления общего доступа, но этот процесс я объясню уже на примере доступа к произвольной папке виртуальной машины.

Доступ с физической машины на виртуальную

Допустим, в корне диска виртуальной машины есть папка Shared. Щелкните по ней правой кнопкой мыши и выберите Общий доступ – Отдельные люди (или Конкретные пользователи в Windows 7).

Теперь вы можете открыть общую папку по сети в проводнике, в том числе введя в адресную строку адрес вида \\имя-компьютера\имя-папки.

Подключение к удаленному рабочему столу виртуальной рабочей машины

В Hyper-V между физической и виртуальной машиной невозможен обмен файлами путем копирования и вставки. Можно лишь вставлять скопированный на физической машине текст сочетанием клавиш Ctrl + V. Однако после запуска виртуальной машины можно соединяться с ней посредством RDP вместо того чтобы открывать ее из диспетчера Hyper-V. Этот способ работает в изданиях Pro и выше.

Действия на виртуальной машине

Сначала нужно разрешить на виртуальной машине подключения к удаленному рабочему столу в свойствах системы. Нажмите Win + R и выполните:

RUNDLL32.EXE shell32.dll,Control_RunDLL sysdm.cpl,,5

Затем разрешите подключение, как показано на рисунке.

Остается лишь выяснить IP-адрес виртуальной машины командой ipconfig

Действия на физической машине

Нажмите Win + R и введите mstsc и раскройте параметры входа.

В открывшемся окне:

- Введите IP-адрес виртуальной машины (обязательно).

- Укажите имя пользователя, в чью учетную запись будет выполнен вход.

- Включите запоминание учетных данных.

- Сохраните параметры подключения.

Вы также можете задать на вкладке «Экран» разрешение меньше того, что используется в физической машине.

Теперь можно обмениваться файлами между физической и виртуальной машинами привычными сочетаниями клавиш Ctrl + C и Ctrl + V.

Какие функции имеет Hyper-V?What features does Hyper-V have?

Hyper-V предлагает множество функций.Hyper-V offers many features. Это обзор, сгруппированный по функциям, предоставляемым или помогающим в работе.This is an overview, grouped by what the features provide or help you do.

Вычислительная среда . Виртуальная машина Hyper-V включает те же основные компоненты, что и физический компьютер, например память, процессор, хранилище и сеть.Computing environment — A Hyper-V virtual machine includes the same basic parts as a physical computer, such as memory, processor, storage, and networking. Все эти части имеют функции и параметры, которые можно настроить разными способами для удовлетворения различных потребностей.All these parts have features and options that you can configure different ways to meet different needs. Хранилище и сеть могут считаться своими категориями, так как их можно настроить различными способами.Storage and networking can each be considered categories of their own, because of the many ways you can configure them.

Аварийное восстановление и резервное копирование . для аварийного восстановления реплика Hyper-V создает копии виртуальных машин, предназначенные для хранения в другом физическом расположении, чтобы можно было восстановить виртуальную машину из копии.Disaster recovery and backup — For disaster recovery, Hyper-V Replica creates copies of virtual machines, intended to be stored in another physical location, so you can restore the virtual machine from the copy. Для резервного копирования Hyper-V предлагает два типа.For backup, Hyper-V offers two types. В одном из них используются сохраненные состояния, а в другом используется служба теневого копирования томов (VSS), что позволяет создавать резервные копии, совместимые с приложениями, для программ, поддерживающих VSS.One uses saved states and the other uses Volume Shadow Copy Service (VSS) so you can make application-consistent backups for programs that support VSS.

Оптимизация . Каждая поддерживаемая гостевая операционная система имеет настроенный набор служб и драйверов, называемый службами Integration Services, которые упрощают использование операционной системы на виртуальной машине Hyper-V.Optimization — Each supported guest operating system has a customized set of services and drivers, called integration services, that make it easier to use the operating system in a Hyper-V virtual machine.

Переносимость — такие функции, как динамическая миграция, миграция хранилища и импорт и экспорт, упрощают перемещение и распространение виртуальной машины.Portability — Features such as live migration, storage migration, and import/export make it easier to move or distribute a virtual machine.

Удаленное подключение . Hyper-V включает подключение к виртуальной машине, средство удаленного подключения для использования с Windows и Linux.Remote connectivity — Hyper-V includes Virtual Machine Connection, a remote connection tool for use with both Windows and Linux. В отличие от удаленный рабочий стол, это средство предоставляет доступ к консоли, что позволяет увидеть, что происходит на гостевом компьютере, даже если операционная система еще не загружена.Unlike Remote Desktop, this tool gives you console access, so you can see what’s happening in the guest even when the operating system isn’t booted yet.

Безопасность — безопасная загрузка и экранированные виртуальные машины помогают защититься от вредоносных программ и другого несанкционированного доступа к виртуальной машине и ее данным.Security — Secure boot and shielded virtual machines help protect against malware and other unauthorized access to a virtual machine and its data.

Сводные сведения о функциях, появившихся в этой версии, см. в статье новые возможности Hyper-V в Windows Server.For a summary of the features introduced in this version, see What’s new in Hyper-V on Windows Server. Некоторые функции или части имеют ограничение на количество, которое можно настроить.Some features or parts have a limit to how many can be configured. Дополнительные сведения см. в разделе Планирование масштабируемости Hyper-V в Windows Server 2016.For details, see Plan for Hyper-V scalability in Windows Server 2016.