Парсинг

Содержание:

- Как работают парсеры поисковых запросов

- Как работать в программе

- Кому и зачем нужны парсеры сайтов

- Чек-лист по выбору парсера

- Интерфейс

- Персональные данные

- Алгоритм работы парсера

- Программы и сервисы для парсинга

- Как пользоваться парсером Wordstat от Click.ru

- Находим упущенные ключевые слова

- Очистка СЯ от «мусора»

- Парсеры сайтов по способу доступа к интерфейсу

- Распределение семантического ядра: внешняя оптимизация сайта

- Мутаген

- Зачем нужен Kparser?

- Как создать семантическое ядро?

- Для чего нужен парсер?

Как работают парсеры поисковых запросов

После того как вы собрали базу ключей и расширили ее с помощью Вордстат, можно воспользоваться платным сервисом, чтобы очистить значимые фразы и составить семантическое ядро. Рассмотрим, как это сделать, на примере Кей Коллектора

- Открываем «Файл» -> «Новый проект» и устанавливаем регион.

- Нажимаем «Пакетный сбор слов из левой колонки Yandex.Wordstat», копируем уже имеющийся список и нажимаем «Начать сбор».

Запросы с базовой частотностью (БЧ) ниже 5 являются мало запрашиваемыми и принесут мало трафика, поэтому их лучше удалить.

Чтобы автоматизировать этот процесс, перед началом сбора слов устанавливаем в настройках нижнюю границу БЧ, которая будет включена в конечный результат.

С помощью удобных программ и нехитрых действий вы сможете собрать базу ключей, даже если вы новичок.

Используете функцию парсинга ключевых запросов? Делитесь опытом в комментариях!

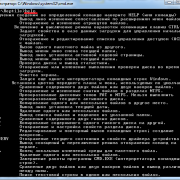

Как работать в программе

Теперь мы кратко разберемся, как пользоваться этой программой. Сложностей тут никаких нет. Но все равно стоит дать небольшую инструкцию, которая будет включать в себя последовательность действий и обзор некоторых функций.

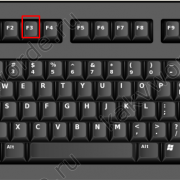

Для начала вы должны создать проект. Идем в главное меню (кнопочка Еб в углу), нажимаем на “Создать проект”. Выскочит окно нашего файлового менеджера, где нам будет предложено заполнить поле “Имя” и сохранить наш файл проекта в каком-то месте.

Это все делается на ваше усмотрение. Но лучше сохранять проекты в той же папке, где и сам Словоеб. После того, как вы кликнете “Сохранить”, проект откроется в окне программы.

В нижней части программы мы видим настройки регионов для Яндекса и Гугла. Самая первая отвечает за Яндекс.Вордстат, вторая – за Директ, третья – Гугл. Также тут есть кнопка обновления, которая поможет вам в случае, если программа начнет тупить.

Чуть выше вы можете видеть вкладки: “Новости” – которых уже не было 2 года, “Журнал событий” – лог всех операций, производимых через утилиту, и “Статистика” – тут будет отображаться статистика по собранным ключевикам.

Еще выше у нас расположилось большое поле, где будут все запросы и их частотности. Вся информация представлена в виде удобной таблицы.

Рядом “Управление группами”. С помощью этого инструмента вы сможете разбивать запросы на группы и работать уже с ними.

В самом верху у нас находятся инструменты для работы с семантическим ядром. Самая первая из доступных нам кнопок позволяет работать с минус-словами. Туда можно вписать слова и фразы, которые программа должна игнорировать при сборе ядра.

Рядом идут инструменты для работы с Вордстатом и поисковыми подсказками. Вы можете собрать ключи из левой колонки Вордстата (с наличием самого ключа в запросах), правой колонки (похожие запросы). После этого можно собрать поисковые подсказки или проверить корректность словоформ. Здесь же инструменты для вычисления KEI и сбора частотностей.

Для добавления своих поисковых фраз вы должны перейти во вкладку “Данные”, нажать на кнопку “Добавить фразы”. У вас выскочит окно, куда вы сможете ввести одну или несколько поисковых фраз.

Поисковые фразы можно добавлять в текущую группу, либо же создать новую. Также вы можете воспользоваться функцией “Загрузить из файла”. Программа работает только с TXT-файлами, поэтому если вы сохраняли поисковые фразы где-то еще – самое время перенести их в блокнот. После этого вы сможете собрать частотности или провести любые другие операции с этими данными.

Как только работа по сбору семантического ядра и очистке его от лишнего мусора будет закончена, вы должны экспортировать всю информацию в файл. Для этого найдите в левом верхнем углу иконку с Excel-файлом и кликните на нее. Далее вновь откроется окно файлового менеджера, используя которое вы и сохраните файлик с таблицей.

Вы можете сохранить проект и вернуться к работе над ним позже. Для этого нажмите на иконку сохранения, также выберите папку через файловый менеджер и кликните на “Сохранить”.

Кому и зачем нужны парсеры сайтов

Парсеры экономят время на сбор большого объема данных и группировку их в нужный вид. Такими сервисами пользуются интернет-маркетологи, вебмастера, SEO-специалисты, сотрудники отделов продаж.

Парсеры могут выполнять следующие задачи:

Кому и для каких целей требуются парсеры, разобрались. Если вам нужен этот инструмент, есть несколько способов его заполучить.

- При наличии программистов в штате проще всего поставить им задачу сделать парсер под нужные цели. Так вы получите гибкие настройки и оперативную техподдержку. Самые популярные языки для создания парсеров — PHP и Python.

- Воспользоваться бесплатным или платным облачным сервисом.

- Установить подходящую по функционалу программу.

- Обратиться в компанию, которая разработает инструмент под ваши нужды (ожидаемо самый дорогой вариант).

С первым и последним вариантом все понятно. Но выбор из готовых решений может занять немало времени. Мы упростили эту задачу и сделали обзор инструментов.

Чек-лист по выбору парсера

Краткий чек-лист, который поможет выбрать наиболее подходящий инструмент или сервис.

- Четко определите, для каких задач вам нужен парсер: анализ SEO конкурентов или мониторинг цен, сбор данных для наполнения каталога, съем позиций и т.д.

- Определите, какой объем данных и в каком виде нужно получать.

- Определите, как часто вам нужно собирать данные: единоразово или с определенной периодичностью (раз в день/неделю/месяц).

- Выберите несколько инструментов, которые подходят для решения ваших задач. Попробуйте демо-версии. Узнайте, предоставляется ли техническая поддержка (желательно даже протестировать ее — задать парочку вопросов и посмотреть, как быстро вы получите ответ и насколько он будет исчерпывающим).

- Выберите наиболее подходящий сервис по соотношению цена/качество.

Для крупных проектов, где требуется парсить большие объемы данных и производить сложную обработку, более выгодной может оказаться разработка собственного парсера под конкретные задачи.

Для большинства же проектов достаточно будет стандартных решений (возможно, вам может быть достаточно бесплатной версии любого из парсеров или пробного периода).

Интерфейс

Итак, всё начинается с поля «Enter URL to spider», куда вводится название сайта и жмётся кнопка «Start».

Понятное дело, что она запускает сканирование сайта, а когда оно завершится, мы можем приступать к анализу. И тут мы сразу получаем первые минусы по сравнению с PageWeight — нельзя задать локальный (то есть свой) роботс. В принципе, исключить разделы из сканирования можно через Configuration — Exclude, но это уже не так удобно. Впрочем, познакомимся с интерфейсом и возможностями программы.

Сначала может ввести в ступор, что в списке страниц будет куча изображений, но их можно моментально отсечь — либо выбрав фильтр HTML (кстати кнопка Export отвечает за экспорт текущих результатов из главного окна в Excel, можно даже в xlsx):

Либо переключившись на HTML в сайдбаре, оба варианта оставят в основном окне программы только собственно HTML страницы:

В последней версии (3.0 на момент написания статьи) появилась возможность выстроить структуру сайта. Таким образом можно, к примеру, изучить структуру конкурентов перед созданием своего сайта.

Заметьте, что у каждой вкладки программы есть свои собственные фильтры. Вы можете выбрать, например, только страницы, отдающие 301 редирект и выгрузить их в Excel. На вкладке URI вы можете выбрать урлы, чья длина больше 115 символов, урлы с нижним подчеркиванием вместо дефиса (фильтр Underscores), дубли страниц (Duplicate), урлы с параметрами (Dynamic). На вкладке Title — выбрать те тайтлы, чья длина больше 65 символов или меньше 30, совпадающие с H1 на странице, отсутствующие. На вкладке Images — все изображения больше 100 килобайт, без тега alt. Ну и так далее.

Столбцы в основном окне перемещаются по принципу Drag and Drop, так что можно переместить наиболее важные из них ближе к левой части окна и сохранить настройки через File — Default Config — Save Current.

При нажатии на название столбца происходит сортировка. Среди столбцов есть не совсем обычные:

- Title 1 Lenght — длина Title

- Title 1 Pixel Width — ширина Title в пикселях

- Level — это уровень вложенности.

- Word Сount — количество слов между тегами body.

- Size — вес страницы в байтах.

- Inlinks — количество внутренних ссылок на страницу.

- Outlinks — количество внутренних ссылок со страницы.

- External Outlinks — количество внешних ссылок со страницы. Поспорьте с пацанами, кто угадает, какое наибольшее количество ссылок со страницы размещает тот или иной сапа-сайт. Если один угадает, а второй нет — то второй покупает ссылку на свой сайт с этой страницы.

- Response Time — время загрузки страницы.

Также внизу есть окно с более подробной информацией о странице. Так, SERP Snippet показывает, как, по оценке программы, будет выглядеть сниппет в Google. Полезно, если вы заморачиваетесь, чтобы Title в выдаче выглядел кликабельнее.

Когда в окне кликаете правой кнопкой мыши на строку нужного урла, открывается контекстное меню, из которого наиболее важным пунктом является Open in Browser — открыть в браузере.

Также удобно будет выделить с помощью shift часть урлов и удалить их через Remove. Не с сайта, конечно, а из результатов сканирования. А то бы я давно с пары сайтов кое-каких чертей урлы бы поудалял…

Также с помощью контекстного меню можно проверить наличие страницы в индексе Гугла, Яху и Бинга, посмотреть бэклинки через сервисы типа Majestic SEO или Ahrefs, открыть кэш Гугла или найти страницу в Вебархиве. Ну еще роботс глянуть и проверить код страницы на наличие ошибок. Контекстное меню на всех вкладках одинаковое.

Персональные данные

Месяц назад мне пришлось бы долго рассуждать на тему общедоступных персональных данных. С 1 марта 2021 года всё стало просто: чтобы законно собирать персональные данные из интернета, нужно получить согласие каждого человека, чьи данные собираются. То, что человек сам разместил свои данные в открытом доступе, больше не имеет значения. На Хабре есть статья о законе, который де-факто запретил парсинг общедоступных персональных данных, поэтому долго рассуждать на эту тему не буду. Кроме того, есть статья на Roem.ru, где объясняются возможные причины принятия этого закона.

Есть один вариант, при котором собирать общедоступные персональные данные всё же можно без согласия каждого конкретного человека: сайт, на котором размещены такие данные, взял у человека согласие на распространение. Иначе говоря, если условный «ВКонтакте» попросит у всех пользователей согласие не только на обработку, но и на распространение персональных данных, то парсинг профилей ВКонтакте снова станет законным — во всяком случае, с точки зрения персональных данных. Однако вряд ли ВКонтакте станет так делать: по делу «ВК против Дабл» можно сделать вывод, что социальная сеть, наоборот, была бы рада максимально затруднить парсинг.

Алгоритм работы парсера

Парсер работает следующим образом: он анализирует страницу на наличие контента, соответствующего заранее заданным параметрам, а потом извлекает его, превратив в систематизированные данные.

Процесс работы с утилитой для поиска и извлечения найденной информации выглядит так:

- Сначала пользователь указывает вводные данные для парсинга на сайте.

- Затем указывает список страниц или ресурсов, на которых нужно осуществить поиск.

- После этого программа в автоматическом режиме проводит глубокий анализ найденного контента и систематизирует его.

- В итоге пользователь получает отчет в заранее выбранном формате.

Естественно, процедура парсинга через специализированное ПО описана лишь в общих чертах. Для каждой утилиты она будет выглядеть по-разному. Также на процесс работы с парсером влияют цели, преследуемые пользователем.

Программы и сервисы для парсинга

Для начала нужно подобрать около 20 базовых фраз. Для этого используем свой мозг (подумайте, какие словосочетания ассоциируются с вашим родом деятельности), поисковую выдачу по схожим запросам и данные из Яндекс.Метрики и Google Search Console (смотрим, по каким ключам больше переходов на ваш сайт).

Далее для создания хорошего семантического ядра используем специальные программы.

Бесплатные

Часть работы можно проделать, не заплатив ни копейки. Здесь на помощь приходят определенные сервисы.

Wordstat Yandex

- показывает количество и частоту запросов в Яндексе;

- фразы изменяются в падежах;

- можно задать регион;

- позволяет сделать выборку по типу устройства (ПК, планшет, смартфон);

- позволяет исключить лишние фразы.

Планировщик ключевых слов Google

- подходит для узкой тематики;

- позволяет собрать широкую базу ключей;

- показывает статистику по словам;

- прогнозирует эффективность фраз.

Букварикс

- содержит большую базу запросов;

- функции фильтрации минимальны.

При использовании бесплатных ресурсов семантическое ядро получается «грязным» — словосочетания дублируются, выдаются нерелеватные запросы, слова с нулевой частотностью, которые приходится чистить с помощью фильтров или вручную.

Платные

Для расширения ядра советуем воспользоваться платными сервисами.

Rush Analytics

- автоматизирует сбор и группировку значимых словосочетаний;

- парсит запросы через Wordstat;

- регулируемая глубина поиска;

- классифицирует запросы по типам (коммерческие и информационные).

База Пастухова

- большая база ключевых слов (на русском и английском языке);

- фильтрует запросы по числовым данным;

- есть онлайн-версия;

- из-за дороговизны больше подходит крупным компаниям.

Serpstat

- комплексный сервис для продвижения ресурса;

- выделяет запросы, по которым проект попадает в ТОП-100 выдачи;

- возможность анализировать сайты конкурентов.

Для наибольшей эффективности советуем комбинировать бесплатные и платные сервисы.

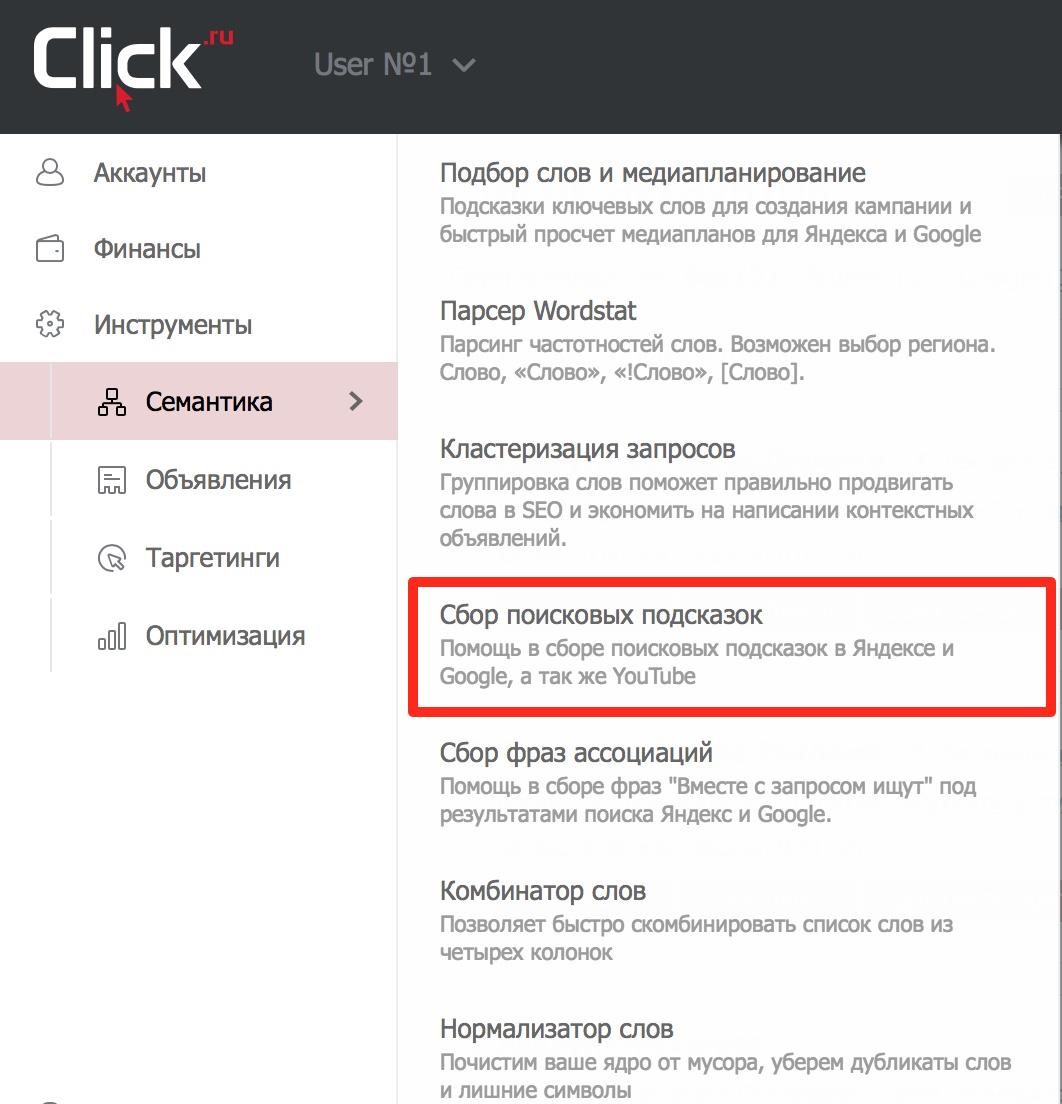

Как пользоваться парсером Wordstat от Click.ru

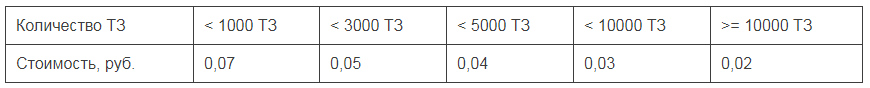

В числе инструментов Click.ru как раз есть функциональный и недорогой парсер Wordstat. Он быстро выдает частотность даже по большому списку запросов. При этом учитывает типы соответствия и региональность. Еще не требует капчу и прокси-серверы, а отчеты позволяет выгружать в Excel и хранить в «облаке».

Для начала работы зарегистрируйтесь в системе Click.ru. После входа в свой аккаунт на главной странице выберите раздел «Парсер частоты Wordstat» и приступайте к работе.

Для начала парсинга перейдите в соответствующий раздел

Как работать с парсером Wordstat после регистрации в Click.ru:

Загрузите список запросов.

Есть два способа: скопировать и вставить ключи в специальное поле или же загрузить XLSX-файл с ними.

При копировании списка учитывайте, что каждый ключ должен идти с новой строки. А в эксель-файле смотрите, чтобы не было вспомогательной информации (названий столбцов, лишних цифр и т. д.). Система берет запросы из первого листа .XLSX по принципу «одна ячейка – один ключ».

Этап загрузки запросов

Выберите регионы.

В системе доступны все регионы Яндекса. Можно посчитать общую частотность по нескольким регионам или получить статистику отдельно по каждому.

Разделять регионы в отчете нужно, если вы планируете продвигать бизнес отдельными региональными поддоменами и посадочными страницами, привязанными к географии. В остальных случаях галочка не ставится.

Выбираем регионы

Укажите тип соответствия.

Широкое соответствие – когда фразы пробиваются как есть – часто показывает обманчивую частотность. Все из-за того, что учитываются все вложенные ключи, в том числе нерелевантные (как в примере с игрушками). То есть всегда лучше перепроверять частоту запроса с помощью специальных операторов.

Кавычки позволяют уточнять статистику по конкретной фразе, без учета вложенных ключей.

Пример

| скачать видео бесплатно – 1 111 285 показов | “скачать видео бесплатно” – 8 493 показа |

Кавычки с восклицательными знаками показывают частотность по заданным словоформам.

Пример

| “!купить !телефон” – 37 909 показов | “!купить !телефоны” – 2 798 показов |

Квадратные скобки – фиксируют порядок слов, что особенно важно в туристическом бизнесе

Пример

| – 4 213 показов | – 1 814 показов |

Все варианты типов соответствия

Запустите проверку.

Время сбора частотностей зависит от количества запросов, регионов и типов соответствия. Если запросов меньше 1 000, процесс займет 1–2 минуты.

Результат будет доступен в списке задач. Можно открыть отчет в браузере или скачать его в формате XLSX.

Здесь будут появляться отчеты со статистикой

Находим упущенные ключевые слова

Собрать все ключи и объявления конкурентов полезно для общего анализа и понимания ситуации

Но если у вас уже запущены рекламные кампании, важно понимать другое: какие слова используют ваши конкуренты, а вы – нет

Как это сделать

1. Подготовьте список ключевых слов, по которым у вас запущена реклама.

2. Перейдите в инструмент «Слова и объявления конкурентов». Укажите домены конкурентов (которые хотите спарсить). В блоке профессиональных настроек вставьте ключи в поле «Минус-слова».

Все слова, добавленные в поле «Минус-слова», система исключит при парсинге. В результатах будут только те ключи, которые вы еще не использовали.

Важно! В блоке профессиональных настроек парсера также есть опция «Точное вхождение без учета морфологии». Если она включена, система не будет собирать указанные ключи в базовом виде, а также с изменением падежа

3. Запустите парсинг и скачайте результаты. На выходе вы получите готовый набор ключей, с помощью которого можете расширить семантику.

Очистка СЯ от «мусора»

Покажем, как это делать в Key Collector.

Ключевики, которые содержат ненужные слова

Нажимаем вкладку выбора условий фильтрации:

Задаем условие, как указано на скриншоте, и пишем слова:

Отмечаем фразы и добавляем в корзину:

Повторы слов

Аналогично вызываем настройки фильтрации фраз и выбираем такой вариант:

Стоп-слова (информационные запросы, города, в которых не действует предложение, «бесплатно», «дешево», субъективные определения и т.д.)

Нажимаем этот значок в верхнем меню:

В окне настроек добавляем фразы (1) и разбиваем по группам (2):

Далее — выделяем слова в таблице галочкой и добавляем в список стоп-слов.

Группы слов

Чтобы разбить запросы на группы, на вкладке «Данные» открываем «Анализ групп». В окне выбираем тип «По отдельным словам»:

Выбранные группы появятся в основном списке запросов, где можно отсеять все ненужные.

Запросы с нулевой частотностью

Выбираем следующее условие фильтрации:

Далее — требования по частоте:

Можно удалить нецелевые запросы и вручную: копируем ключевики в Word. Заменяем пробел на знак абзаца, чтобы представить все слова из словосочетаний в виде колонки. Переносим обратно в Excel на отдельный лист, сортируем и определяем минус-слова. Затем находим с помощью фильтра фразы с ними и удаляем.

На какие вопросы машинный интеллект не дает ответы

Сбор семантики быстрее и проще с помощью различных сервисов, баз, приложений — благо, выбор есть. Однако нельзя слепо полагаться на автоматизацию. Есть два случая, когда без ручного труда не обойтись.

Уже при подборе масок нужно «вытаскивать» синонимы и переформулировки из сайтов заказчика и конкурентов, правой колонки Wordstat, собственных идей и т.д. Мы увидели, что это всё предстоит делать специалисту по контекстной рекламе.

Самый трудозатратный и не автоматизируемый процесс — очистка СЯ от «мусора». Готовых минус-списков и данных об отказах из Яндекс.Метрики недостаточно для 100% точности. Приходится смотреть предварительные списки и выявлять смысловое соответствие результатов бизнесу.

Особенно это касается сложных продуктов. Например, подготовка сжатого воздуха, или осушка воздуха. Больше расширений можно насобирать по слову «осушка».

Но среди результатов в Wordstat в мы можем увидеть и «осушка газа», и «адсорбционная осушка», и «осушка компрессора». Не всегда семантическое соответствие гарантирует смысловое соответствие. Это разные продукты, а значит, разный спрос. Чаще всего выявить и исключить его можно только вручную.

Если вы не проверяете результаты парсинга, вы жертвуете полнотой СЯ и точностью будущих рекламных кампаний. Совет: выбирайте оптимальный баланс «трудозатраты — полнота» и делайте полный список минус-слов.

Парсеры сайтов по способу доступа к интерфейсу

Облачные парсеры

Облачные сервисы не требуют установки на ПК. Все данные хранятся на серверах разработчиков, вы скачиваете только результат парсинга. Доступ к программному обеспечению осуществляется через веб-интерфейс или по API.

Примеры облачных парсеров с англоязычным интерфейсом:

- http://import.io/,

- Mozenda (есть также ПО для установки на компьютер),

- Octoparce,

- ParseHub.

Примеры облачных парсеров с русскоязычным интерфейсом:

- Xmldatafeed,

- Диггернаут,

- Catalogloader.

У всех сервисов есть бесплатная версия, которая ограничена или периодом использования, или количеством страниц для сканирования.

Программы-парсеры

ПO для парсинга устанавливается на компьютер. В подавляющем большинстве случаев такие парсеры совместимы с ОС Windows. Обладателям mac OS можно запускать их с виртуальных машин. Некоторые программы могут работать со съемных носителей.

Примеры парсеров-программ:

- ParserOK,

- Datacol,

- SEO-парсеры — Screaming Frog, ComparseR, Netpeak Spider и другие.

Распределение семантического ядра: внешняя оптимизация сайта

Теперь кластеры нужно проанализировать и распределить по посадочным (целевым) страницам вашего сайта. Если есть похожие по смыслу кластеры — не нужно создавать под них отдельные страницы и тем самым плодить дублированный контент. Отбираем из них самый частотный кластер и его используем. Не пытайтесь также распределить на одной странице сразу несколько кластеров — это не приведет к успеху, придерживайтесь структуры и правила: каждый кластер = отдельному URL на сайте.

Когда вы уже определились с URL-страниц для своих кластеров, нужно подготовить техническое задание, чтобы распределить ключевые слова с точки зрения SEO-оптимизации. Переходим в инструмент Текстовый Анализатор SEO и создаем в нем под каждый кластер отдельный проект. Добавляем ключевые слова и запускаем проект. Текстовый Анализатор проанализирует тексты сайтов-конкурентов из выдачи ТОПа и сгенерирует ТЗ, которые дальше вы можете отправить копирайтеру.

Отдельно про функционал Текстовый Анализатор мы рассказывали в предыдущих материалах:

- Базовое руководство по Текстовому Анализатору

- Статья «Работаем с Текстовым Анализатором»

- Видеоруководство по Текстовому Анализатору

- Вебинар по Текстовому Анализатору

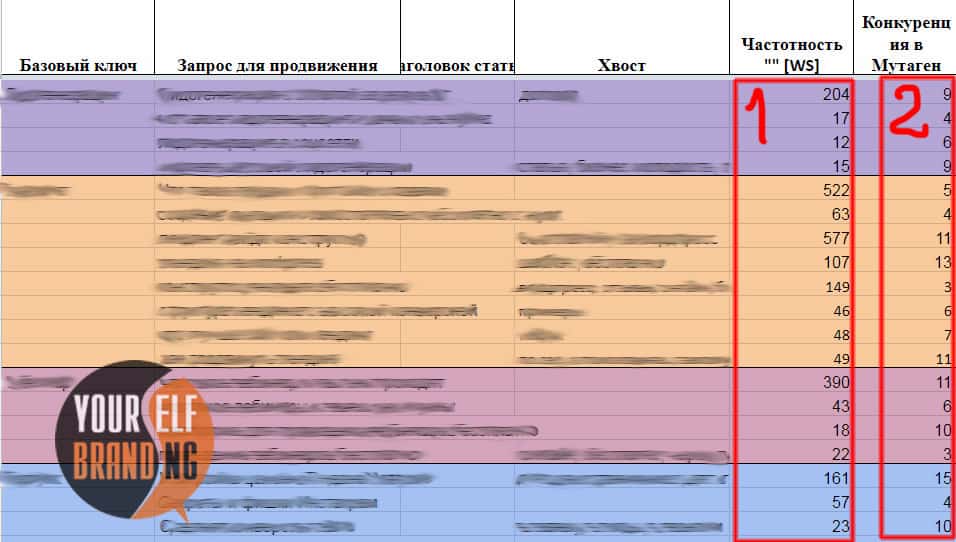

Мутаген

Следующий прекрасный сервис — это Мутаген. Помимо базового показа количества показов ключа в месяц, тут еще можно посмотреть уровень конкуренции по заданной фразе. А весь список собранных ключей потом экспортировать.

Давайте взглянем на интерфейс:

Вводим ключ в поле и получаем следующее:

Уровень конкуренции определяет то, насколько сложно выйти в топ поисковой выдачи по этому ключу. Максимальная конкуренция — это 25, а минимальная — 1.

По своему опыту скажу, что нормальная конкуренция — это примерно до 12. Тогда вы сможете попасть в поисковую выдачу без особых трудностей. Если конкуренция выше 12, будет сложно. Нужно потратить много времени на написание действительно интересной и хорошо оптимизированной статьи.

Поэтому важно выбирать ключевые запросы с более низким уровнем конкуренции, в этом и помогает сервис Мутаген. Как и в Яндекс.Wordstat, при нажатии на один из ключей списка вы получите статистику уже конкретно по нему

Как и в Яндекс.Wordstat, при нажатии на один из ключей списка вы получите статистику уже конкретно по нему.

Если по вашей тематике вам не удается найти много ключей, чтобы собрать для статьи большую базу, не стоит брать запросы более высокого уровня конкуренции. Это не поможет. Соберите все ключи, которые вы найдете для вашей ниши, и используйте только их. Даже если их мало.

Пример: запрос «seo копирайтинг заказать» имеет уровень конкуренции 10, но вы не можете найти схожие ключи для расширения семантики. Не стоит в таком случае брать ключ «копирайтинг заказать».

Зачем нужен Kparser?

На официальном сайте найдете несколько полезных статей с описанием способов применения Kparser. Например:

- В Youtube — осуществляет подбор тегов и ключевых слов с «длинным хвостом» для видео, которые бы отлично охарактеризовали ролик и были максимально эффективны с точки зрения продвижения.

- Google — сбор подсказок под SEO и Adwords. Используя совместно сервисы Adwords Keyword Tool и Kparser, вы достигнете лучшего результата по выборке. Причем последний выдает в разы больше информации + доступен всем пользователями.

- Google Search Console — соединение данных из двух инструментов позволит улучшить показатели органического трафа. Собирайте релевантные подсказки для тайтлов/текстов имеющихся страниц либо делайте новые под ключевые запросы с хорошим потенциалом.

- Определяйте минус слова под ваши Adwords и Direct кампании.

- Google Search Trends — ищите трендовые направления для создания актуального контента + формируйте через Kparser фразы с длинным хвостом.

- eBay + Amazon — по аналогии с Youtube и другими нишевыми продуктами рассматриваемый проект помогает определять релевантные ключи и поднять ваш товар повыше в выдаче.

Советую хорошенько изучить все эти инструкции, т.к. там весьма детально рассмотрены ситуации, в которых Kparser позволит выжать максимум из того или иного сервиса. К сожалению, пока что информация представлена только на английском.

Возьмем к примеру Youtube…

По правилам хорошей оптимизации ролика вам нужно:

- придумать наиболее релевантный ключевой запрос для видео;

- использовать его в имени загружаемого файла, заголовке и других элементах на странице;

- создать хорошее описание с вашими ключевиками и похожими по смыслу фразами;

- добавить запросы в теги, по которым должны находить данное видео;

- напоследок поделитесь роликом во всех своих социальных аккаунтах и, возможно, попросите об этом друзей либо закажите небольшую рекламу — надо постараться сделать своего рода вирусный эффект после публикации.

Теги для видоса — очень важны. Если их не указываете, то получите нулевую оценку параметра vidIQ. С заполненными полями результат явно получше:

Теги добавляются дабы поисковики понимали о чем ваше видео и, соответственно, по каким запросам в Youtube оно будет ранжироваться.

Если у вас новый канал, старайтесь использовать менее конкурентные ключевики с длинным хвостом — так больше шансов побороться за трафик. Популярным авторам есть смысл вклиниться в борьбу по крутым тегам. Найти подходящие варианты вам как раз и поможет текущий инструмент.

Как создать семантическое ядро?

Формирование семантического ядра — это комплексный процесс, включающий анализ тематики и структуры сайта, работу со специальными сервисами и программами, редактирование базы ключей вручную. Есть два основных принципа создания СЯ:

- подбор максимального количества ключей и дальнейшей очистки;

- подбор точных ключевых фраз с самого начала с последующим расширением базы.

Мы обратились к нескольким SEO-экспертам, чтобы узнать, какой подход они предпочитают.

Тарас Гуща, СЕО в SEO.UA, склоняется к первому методу:

Лучше много ключей и потом чистить. Потому как иногда можно упустить весьма стоящие ключевые фразы. Нам как профессионалам продвижения сайтов надо давать клиентам максимальный результат. Поэтому каждая ключевая фраза, которая может конвертировать потенциальную аудиторию в клиента, очень важна.

А вот Катерина Золотарева, Founder & CEO в Site24, считает, что в зависимости от выбранной стратегии можно использовать оба подхода:

Если проект небольшой или в сложной для формирования семантики нише, например, технологические услуги, то однозначно надо собирать все и даже больше, потом вычеркивать нерелевантное, а околотематические ключи отправлять в блог.

Также имеет смысл глубоко заниматься семантикой, если проект уже имеет позиции, трафик, а стандартные базовые ключи и так уже включены в метатеги и текст. Тогда глубокая проработка семантики поможет вам значительно улучшить видимость и трафик.

Этапы создания семантического ядра

Создание СЯ можно разделить на три этапа.

- Выбор подхода для создания СЯ.

Есть несколько стратегий того, как можно собрать семантического ядро. Их применяют в зависимости от того, имеет ли ресурс структуру или только находится в процессе разработки, какой у него уровень оптимизации, какие позиции по ключевым словам он занимает и т.д..

- Сбор запросов с помощью специальных инструментов.

Сервисы подбора ключевых слов дают возможность охватить максимальное число запросов и поисковых подсказок. Для лучшего результата стоит задействовать инструменты для анализа семантики конкурентов.

- Формирование СЯ из общей базы запросов.

Этапы преобразования облака тематических запросов в семантическое ядро включают два основных этапа:

- очистка базы ключей от ненужных запросов;

- кластеризация путем деления семантики на группы.

Также в процессе анализа ключей можно отделить минус-слова. Кластеризация базы запросов предшествует распределению ключевых фраз по URL. В следующих разделах мы рассмотрим все этапы разработки семантического ядра подробно.

Подходы при создании семантического ядра

Рассмотрим стандартные схемы для создания баз ключей. В зависимости от конкретного случая можно использовать один из подходов, приведенных ниже, или же индивидуальную стратегию.

ПЕРВЫЙ ПОДХОД — ФОРМИРОВАНИЕ СТРУКТУРЫ НОВОГО САЙТА НА ОСНОВЕ СЯ.

- Исследование рыночной ниши/торговой линейки/брифа клиента.

- Определение списка основных запросов (seed keywords).

- Сбор максимального количества фраз для каждого основного ключа.

- Сбор ТОП-20 ключевых фраз, по которым ранжируются основные конкуренты.

- Очистка полученного списка запросов от дублей и мусорных фраз (при наличии списка минус-слов).

- Автоматическая кластеризация через SE Ranking.

- Окончательная очистка запросов.

- Создание структуры сайта по разделам, категориям, страницам на основе кластеризации.

ВТОРОЙ ПОДХОД — СБОР СЯ ПОД ГОТОВУЮ СТРУКТУРУ САЙТА

- Анализ структуры и разделов сайта.

- Определение списка основных запросов.

- Сбор ТОП-20 ключевых фраз, по которым ранжируются основные конкуренты.

- Сбор максимального количества релевантных ключевых фраз для запросов из п. 2 и 3.

- Очистка от мусорных и нерелевантных фраз.

- Разделение собранных запросов под существующие категории и страницы.

ТРЕТИЙ ПОДХОД — ОБНОВЛЕНИЕ СЕМАНТИЧЕСКОГО ЯДРА ДЛЯ САЙТА.

- Анализ существующей семантики сайта.

- Поиск «слабых мест»: сбор актуальных запросов в тематике, изучение поисковых подсказок, анализ конкурентов для определения недостающих ключей.

- Создание списка упущенных запросов и распределение их по разделам, категориям, страницам.

Для чего нужен парсер?

Можно много говорить о том, для чего нужен парсер. Это и всевозможное извлечение контактных сведений при разработки базы потенциальных клиентов. Так и поиск непосредственно по ней в собственном вэб-ресурсе. При этом будут найдены не внешние ссылки, а вхождение поискового запроса, вбитый пользователем.

Необходимость в программе возникает при сборе ссылокSEO специалистами. Все они знают, что такое язык поисковых запросов и как отражается это в их работе. Они используют парсер для того, чтобы оценить количество ссылок и ссылаемых ресурсов.

Когда требуется работать с большим количеством ссылок, парсер – незаменимый инструмент в оптимизации. Он без проблем соберет информацию и распарсит ее в удобном виде.